在深度学习中,优化器是一个非常重要的组成部分,它决定了模型在训练过程中如何调整参数以最小化损失函数。随机梯度下降(SGD)是最经典和常用的优化算法之一,本文将重点介绍和解释SGD的概念、算法原理以及在深度学习中的应用和优缺点。

第一部分:SGD概述

一、概念与定义

随机梯度下降(Stochastic Gradient Descent,简称SGD)是基于梯度的一种优化算法,用于寻找损失函数最小化的参数配置。SGD通过计算每个样本的梯度来更新参数,并在每次更新中随机选择一个或一批样本。

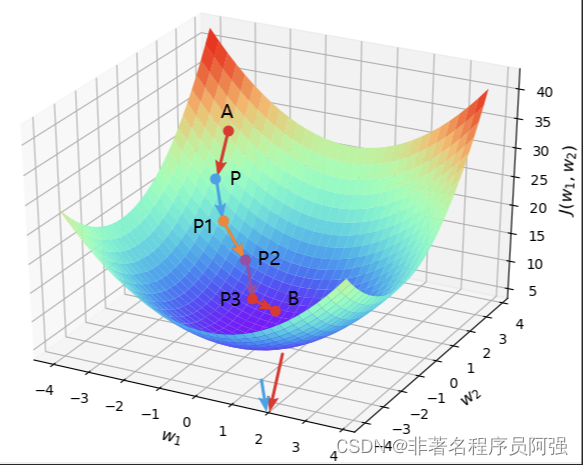

二、算法原理

SGD的原理相对简单。它通过计算损失函数对每个训练样本的梯度来更新参数。具体步骤如下:

- 随机选择一个训练样本;

- 计算该样本的梯度;

- 使用梯度值和学习率来更新参数;

- 重复以上步骤,直至达到收敛条件或达到指定迭代次数。

第二部分:SGD的应用与优缺点

一、应用

SGD在深度学习中广泛应用于模型的训练过程,特别是在大规模数据集和复杂模型的情况下。由于SGD的简单性和高效性,它成为了优化算法领域的基准方法。

二、优点

1. 低计算成本:SGD每次仅使用一个样本或一批样本进行模型参数更新,相比于使用全部样本的批量梯度下降(BGD),计算成本更低。

2. 随机性导致的避免局部极小值:SGD通过随机选择样本来计算梯度,这使得它具有一定的随机性,有助于避免陷入局部极小值。

三、缺点

1. 不稳定性:由于SGD每次更新只使用一个样本或一批样本,更新方向可能受噪声的干扰而波动较大。

2. 需要调整学习率:对于SGD,合适的学习率的选择至关重要。学习率过大可能导致振荡,学习率过小则收敛速度缓慢。

3. 可能陷入局部极小值:由于SGD的随机特性,可能导致在训练过程中陷入局部极小值,并无法跳出。这也是SGD相对于其他优化方法的一个缺点。

第三部分:SGD的改进方法

为了克服SGD的缺点,研究者们提出了一系列改进的优化方法:

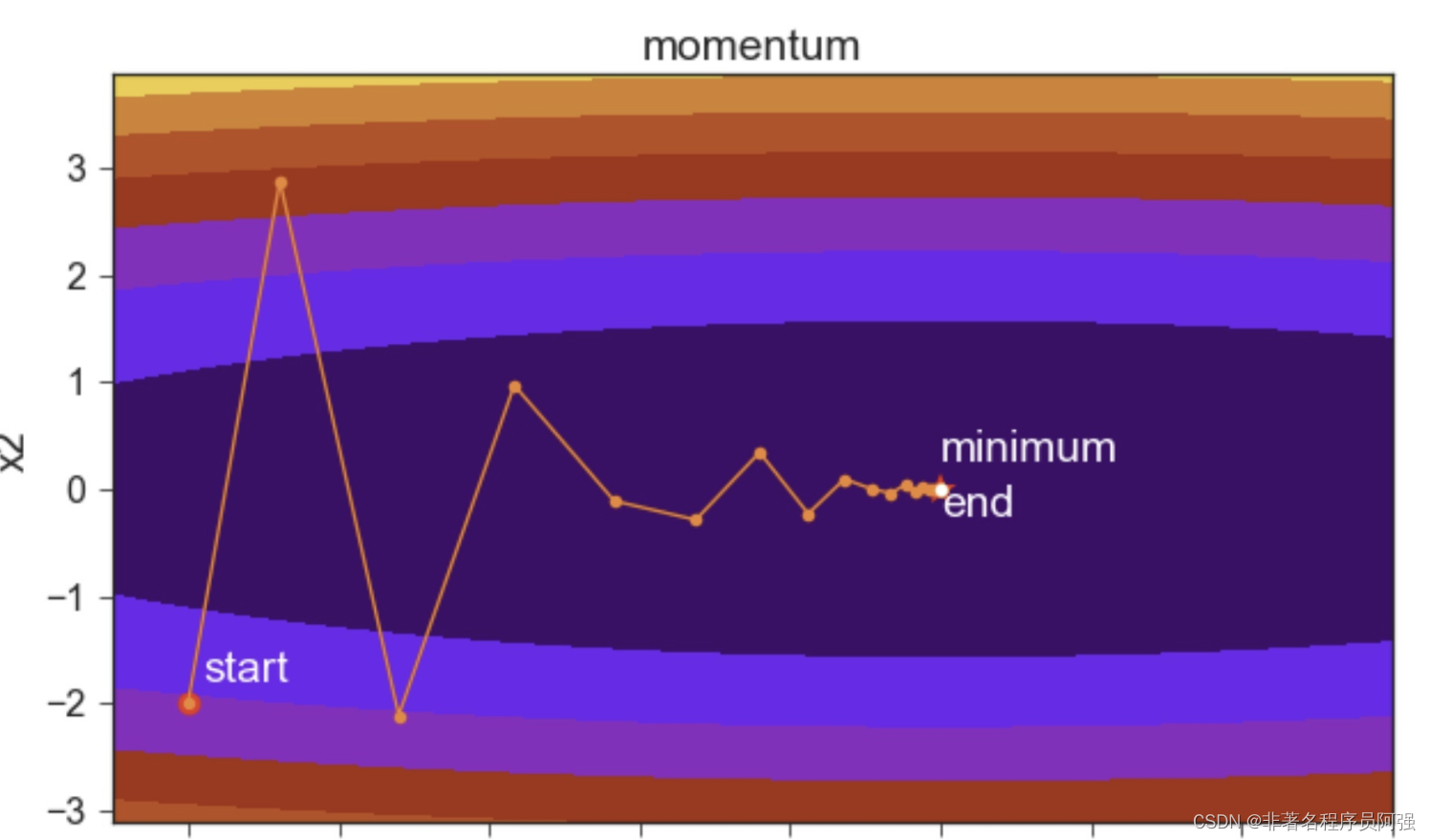

1. 动量法(Momentum):引入一个动量项,使更新方向在梯度变化较大的维度上具有一定的惯性,从而加速收敛并减少震荡。

2. 学习率衰减(Learning Rate Decay):随着训练的进行,逐渐减小学习率,有助于在接近损失函数最小值时平稳收敛。

3. Adagrad:自适应学习率的方法,根据参数在每次迭代中的梯度大小自适应地调整学习率。

4. RMSprop:对Adagrad进行改进,通过平均梯度的平方来调整学习率,从而缓解训练过程中的震荡。

5. Adam:结合了Momentum和Adagrad的优点,并进行了一定的改进和修正,是目前最流行和常用的优化算法之一。

第四部分:总结与展望

本文介绍了随机梯度下降(SGD)算法的概念、原理、应用和优缺点,并讨论了一些改进的优化方法。SGD作为深度学习中最经典和常用的优化算法之一,具有简单性和高效性的优点,广泛应用于大规模数据集和复杂模型的训练。然而,SGD也存在不稳定性和可能陷入局部极小值的缺点,因此改进方法的提出具有重要意义。

随着深度学习技术的发展,优化算法也在不断进步和演变。研究者们不断提出新的方法来解决SGD的不足,并取得了显著的成果。未来,我们有理由相信,优化算法将会继续发展,并在提高模型训练效率和性能方面发挥更重要的作用。深度学习领域也需要更多的优化方法来应对越来越复杂的任务和挑战。

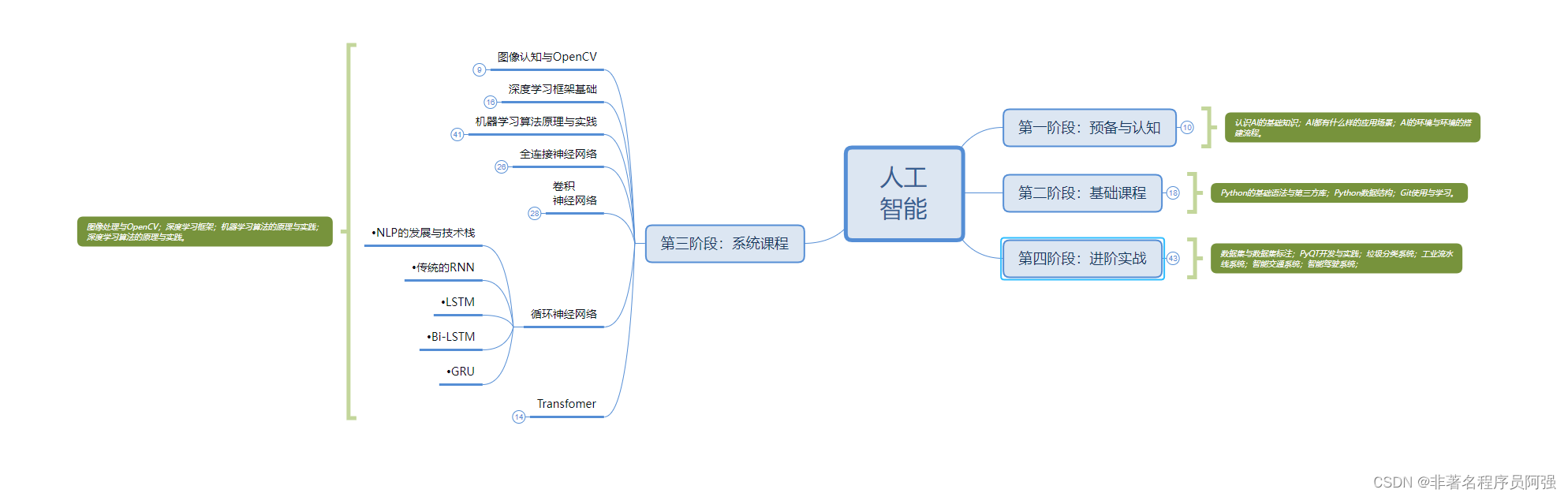

人工智能的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而举步难行。不过别担心,我为大家整理了一份600多G的学习资源,基本上涵盖了人工智能学习的所有内容。点击下方链接,0元进群领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦!扫码进群领资料

公司名称: 亚游-亚游娱乐-注册登录站

手 机: 13800000000

电 话: 400-123-4567

邮 箱: admin@youweb.com

地 址: 广东省广州市天河区88号